Índice

- Chatbot LLM: ¿Qué es un LLM?

- ¿Cómo crear tu propio chatbot LLM? (Desarrollo paso a paso)

- Errores clásicos que se deben evitar al diseñar un asistente LLM

- ¿Cómo utiliza Ringover los LLM en su asistente de IA?

- ¿Por qué la mejora continua es indispensable para los chatbots LLM?

- ¿Se puede realmente optimizar el recorrido de los clientes con un chatbot LLM?

- Chatbot LLM: mucho más que una simple herramienta

- FAQs sobre Chatbot LLM

La inteligencia conversacional está dando hoy un paso decisivo. Gracias a los modelos de lenguaje de gran tamaño (los conocidos chatbot LLM), los chatbots ya no se limitan a recitar guiones fijos: se convierten en verdaderos asistentes IA que participan en las conversaciones con una nueva soltura. Son capaces de adaptarse, reformular, comprender matices e incluso anticipar intenciones.

Esta evolución transforma la forma en que las empresas se comunican con sus clientes, ya sea para asistirlos, guiarlos en su proceso de compra o simplemente hacerles ganar tiempo. Donde antes una respuesta automática solía carecer de pertinencia o sutileza, los nuevos asistentes potenciados por IA ahora pueden mantener una conversación real.

A continuación descubriremos cómo los chatbot LLM están revolucionando los chatbots e identificaremos los errores comunes en la creación de un asistente IA, así como las buenas prácticas para sacarles el máximo provecho. ¡Sigue leyendo!

Chatbot LLM: ¿Qué es un LLM?

Definición: ¿Qué significa exactamente LLM?

Detrás del acrónimo LLM, que significa Large Language Model o modelo de lenguaje de gran tamaño, se esconde una tecnología cuya ambición va mucho más allá de la simple comprensión de texto. Estos modelos representan un avance importante en el campo del procesamiento automático del lenguaje natural, impulsado por un crecimiento exponencial de su complejidad: mientras que las generaciones anteriores manejaban unos pocos millones de parámetros, los LLM actuales manejan miles de millones.

¿Qué posibilidades ofrecen los LLM?

Más allá de las cifras, lo que realmente impresiona son sus capacidades. Estos modelos aprenden a detectar patrones en el lenguaje, identificar intenciones implícitas, generar contenido estructurado e incluso simular razonamientos de forma sorprendente.

En la práctica, esto se traduce en una gran versatilidad: generación de respuestas contextuales, resúmenes automáticos, traducción multilingüe, reformulación de textos, entre muchos otros usos.

La diferencia con los “modelos antiguos”

Lo que los distingue de los sistemas anteriores no es solo su tamaño, sino su capacidad de funcionar de forma transversal, sin necesidad de reprogramarlos para cada tarea. Se les da una instrucción, ya sea precisa o vaga; ellos la interpretan y producen una respuesta. Un poco como un colaborador que aprende rápido… pero que necesita una buena orientación.

Evidentemente, todo esto requiere una fase de entrenamiento masivo, alimentada por enormes corpus extraídos de la web, libros y diálogos humanos. Y si esta abundancia es su fortaleza, también exige cautela: un modelo que lo ha visto todo también puede reproducir lo que “no debería decir”.

¿Cómo funciona un LLM, concretamente?

Veamos bajo el capó de un LLM para observar su arquitectura tan particular: la de los transformers, un tipo de red neuronal que ha redefinido los estándares del procesamiento del lenguaje.

No es coincidencia que estos modelos hayan despegado justo cuando los volúmenes de datos y la potencia de cálculo permitieron superar umbrales que antes eran inalcanzables.

Un LLM se entrena con volúmenes de texto tan grandes que cuesta imaginarlo: a veces varios petabytes, recogidos de libros, sitios web, foros, artículos, etc.

¿Cómo comienza el aprendizaje de un LLM?

En una primera fase, el aprendizaje se realiza sin instrucciones precisas. Esto se conoce como fase no supervisada: el modelo lee, analiza y asimila.

“Aprende” observando, identificando patrones en el lenguaje, coocurrencias y sutilezas de significado que incluso podrían escapar a un lector humano.

Comprender el fine-tuning y el mecanismo de self-attention

Luego viene una fase más dirigida: el fine-tuning. Aquí se ajusta el modelo con datos etiquetados, lo que mejora su precisión en tareas específicas y lo adapta a usos profesionales. Es en esta etapa donde se afinan sus respuestas, se le transmiten intenciones… y se establecen límites.

El núcleo de su funcionamiento se basa en el mecanismo de atención, o más concretamente, de self-attention. En resumen, es la capacidad del modelo para ponderar la importancia relativa de cada palabra en una frase según su contexto.

A diferencia de los enfoques más lineales, aquí todo interactúa con todo. Cada palabra puede influir en la interpretación de las demás, incluso si está lejos en la secuencia. Esto permite al modelo captar sutilezas, ambigüedades y cambios de tono o registro.

La capacidad de “predicción” de los LLM explicada

Una vez entrenado, el modelo funciona según un principio de predicción: genera texto palabra por palabra, teniendo en cuenta lo que ha venido antes. No se trata solo de una imitación, sino de una síntesis probabilística basada en lo que ha visto, aprendido e integrado en las fases anteriores.

Es esta capacidad de continuar una idea de forma fluida y contextual que explica su éxito en aplicaciones como chatbots, asistentes conversacionales o generación de contenido.

Por supuesto, esta mecánica no es infalible. Pero abre un campo de posibilidades que, hasta hace pocos años, parecía más propio de la ciencia ficción que de una herramienta de trabajo.

¿Cómo crear tu propio chatbot LLM? (Desarrollo paso a paso)

La creación de un chatbot LLM es un proyecto estructurado y a veces complejo, que combina estrategia, datos, desarrollo, experiencia de usuario y evolución continua.

Aquí tienes una visión general de las principales etapas para construir un asistente virtual con IA realmente útil para tus usuarios.

1. Establecer las bases para definir el proyecto

Todo comienza con una fase de clarificación. Antes de escribir una sola línea de código, es necesario responder a algunas preguntas clave: ¿Por qué crear este chatbot? ¿Qué tipo de interacciones debe cubrir? ¿Debe guiar, informar, vender, tranquilizar… o un poco de todo eso?

Este trabajo de definición incluye también la identificación de los usuarios objetivo. Comprender sus expectativas, hábitos y problemas ayuda a priorizar los escenarios de uso. En esta fase también se definen los indicadores de éxito, teniendo en cuenta que estos evolucionarán con el tiempo y el uso.

Por último, no hay que olvidar la infraestructura: ¿qué base técnica se utilizará? ¿Qué recursos internos habrá para mantenerlo? ¿Qué datos están disponibles o deben ser recopilados? ¿Qué solución de creación de chatbot se adoptará? Anticipar estos puntos evitará muchos problemas más adelante.

2. Reunir y preparar los datos: la etapa crucial

Un LLM, por potente que sea, depende completamente de los datos que se le proporcionen. Aquí es donde realmente se juega el éxito del proyecto. El objetivo es construir un corpus lo suficientemente rico y representativo como para reflejar las futuras interacciones entre el chatbot y sus usuarios.

Esto implica recopilar conversaciones, tickets de soporte, fragmentos de FAQ, comentarios extraídos del CRM… todo lo que pueda alimentar el modelo con casos reales.

Sin embargo, es esencial limpiar, filtrar y estructurar estos datos. La calidad es más importante que la cantidad, aunque en el mejor de los casos, se busca combinar ambas cosas.

La diversidad es otro criterio clave. Al variar las fórmulas, los tonos y las intenciones, el bot ia se adapta mejor a las situaciones de la vida real. Y, sobre todo, evitar reproducir sesgos perjudiciales para la experiencia.

3. Entrenar el modelo: precisión y equilibrio

Una vez reunidos los datos, llega el momento de afinar el modelo. No siempre es necesario entrenarlo desde cero: utilizar modelos ya existentes y aplicar fine-tuning suele ser más sensato, especialmente en el entorno B2B.

Durante esta fase entran en juego varios parámetros: número de iteraciones, tasa de aprendizaje, reglas de validación… El objetivo no es que el modelo lo sepa todo, sino que sea relevante. Es preferible un chatbot que sea excelente en un ámbito concreto que uno generalista y poco preciso.

4. Diseñar la interfaz: donde todo cobra vida

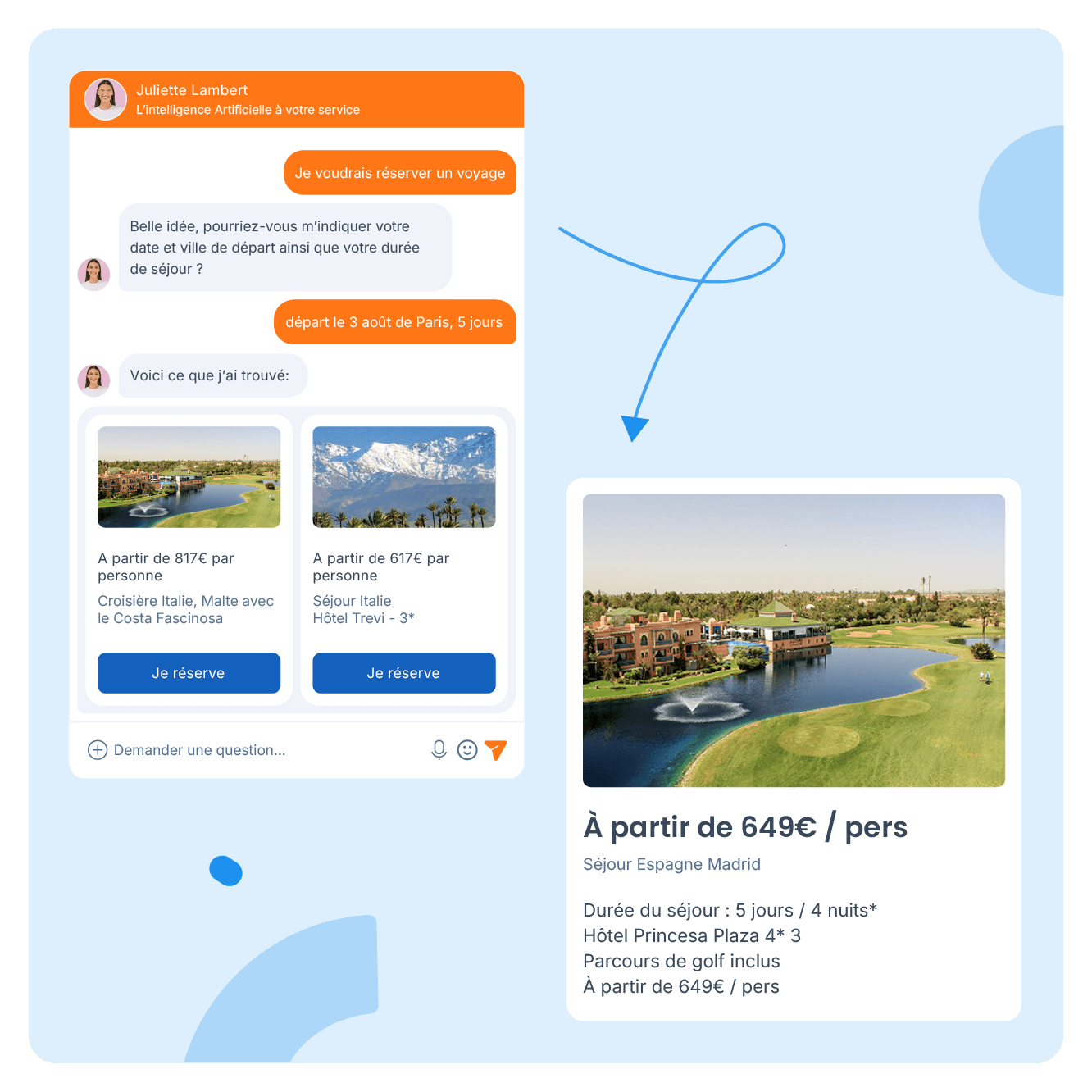

No basta con tener un buen motor; también se necesita una buena “carrocería”. La interfaz es el punto de contacto, donde se da la interacción con el cliente, visitante, prospecto o usuario. Debe ser clara, fluida y sin elementos innecesarios. Si el usuario no entiende cómo funciona el chatbot en los primeros segundos, se irá.

Herramientas como Target First, por ejemplo, ofrecen entornos accesibles para personalizar la interfaz del asistente. Pero no se trata solo del aspecto visual: también es clave gestionar correctamente las entradas del usuario, adaptar las respuestas según el contexto de la conversación e inspirar confianza desde el primer mensaje.

Para casos de uso más complejos, se puede integrar una lógica RAG (Retrieval-Augmented Generation). Esta técnica híbrida permite al chatbot consultar una base de datos documental antes de generar una respuesta, lo que aporta mayor profundidad y precisión. Es especialmente útil en sectores regulados o técnicos.

5. Desplegar, probar, mejorar: un ciclo constante

El momento del despliegue es clave, pero no marca el final del proyecto. En realidad, es cuando todo comienza de verdad.

El chatbot debe ser monitoreado, evaluado y ajustado. Su rendimiento puede cambiar con el tiempo, ya sea por la evolución de las expectativas de los usuarios o por la obsolescencia de los datos. Entre los elementos fundamentales para una mejora continua están:

- La actualización regular del corpus

- Las pruebas con interacciones reales

- Los ajustes de tono o estructura

Sin este seguimiento, el chatbot puede quedar rápidamente desfasado o incluso resultar contraproducente. En resumen: tu herramienta de IA también necesita supervisión.

Errores clásicos que se deben evitar al diseñar un asistente LLM

Incluso con buenas herramientas, un proyecto de chatbot puede desviarse si no se anticipan ciertos errores. Aquí te dejamos una lista de fallos frecuentes en los proyectos de chatbots basados en LLM, junto con consejos prácticos para evitarlos.

1. Empezar el proyecto sin una dirección clara ❌

Este es el error más básico: querer crear un chatbot… sin definir exactamente para qué servirá. El resultado probable será un asistente confuso, que responde de forma incorrecta o incoherente. Desde el punto de vista del usuario, esto supone un gran obstáculo.

Para evitarlo, basta con responder a una pregunta sencilla desde el principio: ¿Qué problema debe resolver el software chatbot?

Si, por ejemplo, debe gestionar preguntas sobre envíos, todo su comportamiento debe girar en torno a eso, ni más ni menos. Cuanto más claro sea el objetivo, más coherente será el asistente.

2. Olvidar personalizar la experiencia ❌

Un chatbot que habla igual con todo el mundo es como un agente de atención al cliente que nunca revisa el historial del cliente. Esta falta de personalización puede resultar frustrante.

Es fundamental conectar el asistente a fuentes relevantes: CRM, historial de compras, preferencias del usuario… En cuanto la experiencia parece "a medida", la interacción se vuelve más fluida. En cambio, si el usuario debe repetir información o buscarla él mismo, el chatbot pierde gran parte de su utilidad.

3. Limitarse a árboles de decisión ❌

Muchos chatbots antiguos se basaban en flujos rígidos: se hace clic en un botón, luego en otro, y así sucesivamente. ¿Qué pasa si la consulta no encaja en ese marco? El chatbot se bloquea o redirige a un formulario.

La integración de IA cambia las reglas. Ahora, el chatbot puede entender peticiones expresadas de forma natural, gestionar imprevistos y ofrecer respuestas inteligentes incluso fuera de los escenarios predefinidos. Es el paso de un asistente "automático" a uno verdaderamente "inteligente".

4. Sobrecargar la base de conocimientos ❌

Incluir toda la documentación posible es una tentación frecuente, pero puede ser contraproducente. Demasiados datos confunden al modelo, que puede acabar mezclando temas o generando respuestas poco claras.

Lo mejor es avanzar por etapas: empezar con un conjunto de conocimientos bien enfocado y estructurado, y ampliarlo poco a poco en función de los usos reales.

5. Lanzar sin una fase real de pruebas ❌

Un chatbot sin pruebas reales es como un coche sin inspección técnica.

Las pruebas deben cubrir todos los escenarios posibles: preguntas comunes, errores de redacción, consultas ambiguas o casos límite. El objetivo es detectar fallos, ajustar los prompts y mejorar las respuestas. Hacer tests es clave para anticipar la mayoría de los problemas tras el lanzamiento.

6. No prever errores (y gestionarlos mal) ❌

Todos los chatbots, incluso los mejores, se enfrentarán tarde o temprano a preguntas que no entienden. No pasa nada, siempre que esté previsto.

Cuando un chatbot no sabe algo, debe expresarlo claramente. Y, sobre todo, ofrecer una alternativa como:

- Reformular la pregunta

- Redirigir a un recurso útil

- Escalar a un humano

El silencio, las respuestas absurdas o los bucles infinitos destruyen rápidamente la confianza.

7. Descuidar la seguridad y la privacidad ❌

Un asistente LLM mal gestionado puede convertirse en una puerta de entrada a usos indebidos: fugas de información, inyecciones de prompts, respuestas no controladas… Los riesgos son reales.

Adoptar una estrategia de Zero Trust es una buena base para limitar estos riesgos y cumplir con normativas como la IA Act, el RGPD, entre otras.

Esto implica filtrar entradas, validar salidas, limitar permisos y segmentar accesos. Y, sobre todo, no exponer datos sensibles o estratégicos sin verificación. La seguridad no debe ser un añadido final: debe estar integrada en la arquitectura desde el principio.

¿Cómo utiliza Ringover los LLM en su asistente de IA?

El asistente de IA de Ringover aprovecha los Modelos de Lenguaje de Gran Tamaño (LLM) para optimizar la experiencia del cliente, reforzar sus capacidades y aumentar la productividad de las empresas.

Una inteligencia moldeada por tus propios datos

Lo que realmente distingue al asistente de IA de Ringover es su capacidad para adaptarse a la realidad específica de tu negocio. A diferencia de los sistemas genéricos, no funciona de forma aislada. Se alimenta de tus datos internos: CRM, catálogo de productos, historial de clientes, etc.

De este modo, puede ajustar sus respuestas con precisión al contexto, sin perderse en respuestas genéricas o irrelevantes.

¿Un pedido pendiente, una reclamación específica, una consulta recurrente, una solicitud de asesoramiento sobre un producto? El asistente las comprende en su contexto y adapta su discurso en consecuencia.

Va más allá del típico chatbot con guion, para entrar en una lógica de servicio verdaderamente contextualizado: es un verdadero asistente de IA.

Generativo, pero no mecánico

La integración de la IA generativa abre otra dimensión: la de una conversación viva, que simula notablemente el lenguaje natural. Gracias a las técnicas avanzadas de NLP (procesamiento automático del lenguaje), el asistente de Ringover navega con soltura entre intenciones, diversas formulaciones e incluso imprecisiones propias de los intercambios humanos.

No se limita a "responder", aconseja, propone, reformula. Así, transforma una simple consulta en una oportunidad de interacción o conversión. Esta misma lógica, aplicada por Target First, fue la que convenció a Ringover para adquirirla en 2025.

Una presencia continua

Uno de los aportes concretos de esta tecnología se manifiesta en la gestión del soporte al cliente. El asistente de Ringover garantiza una continuidad del servicio sin interrupciones, siendo capaz de gestionar en cualquier momento las solicitudes estándar —seguimiento de pedidos, consultas sobre servicios, problemas frecuentes.

Este funcionamiento reduce significativamente la carga sobre los equipos humanos, que pueden así concentrarse en casos más complejos, llamadas sensibles o en la relación a largo plazo.

En la práctica, esto se traduce en tiempos de respuesta más cortos, mayor satisfacción del usuario y una mejora en la calidad del servicio ofrecido.

¿Por qué la mejora continua es indispensable para los chatbots LLM?

La mejora continua no es una opción: es una necesidad operativa, estratégica y tecnológica.

Una respuesta ágil en un entorno en constante evolución

Los comportamientos de los usuarios no siguen un patrón fijo. Evolucionan con las tendencias, los hábitos, los contextos culturales o incluso económicos.

Al integrar regularmente nuevos datos, un asistente de IA puede ajustar sus respuestas y afinar sus prioridades. También puede seguir aportando valor allí donde se espera, sin caer en respuestas fuera de lugar.

Esta agilidad no se improvisa, se organiza. Es mediante un ciclo de ajustes sucesivos que el modelo aprende a interpretar las señales débiles. Son esos indicios sutiles pero decisivos los que marcan la diferencia entre una interacción útil y una interacción olvidable.

Una palanca para afinar la pertinencia de las respuestas

Incluso los mejores modelos pueden cometer errores. Pueden malinterpretar una palabra, desviarse con una respuesta demasiado genérica o proponer una solución desconectada del contexto.

Aquí es donde la mejora continua actúa como filtro y catalizador, ya que permite corregir desviaciones, reducir sesgos y aumentar la precisión de las respuestas ofrecidas.

El fine-tuning, junto con procesos rigurosos de validación, garantiza que el modelo no se limite a responder, sino que lo haga de forma adecuada y contextualizada.

La RAG: una puerta abierta hacia innovaciones tecnológicas

El universo de la IA está en constante cambio. Surgen nuevas arquitecturas, y métodos como la RAG (retrieval-augmented generation) empujan los límites del tratamiento de la información. También se vuelve común la integración de interfaces por voz.

Ignorar estos avances es arriesgarse a que el chatbot inteligente quede obsoleto lenta pero inevitablemente. Por el contrario, adoptar una dinámica de mejora continua permite mantener un impulso tecnológico, seguir siendo competitivo y anticipar las expectativas del público.

Una vigilancia reforzada sobre la seguridad de los intercambios

Detrás de cada línea de código hay datos. Y detrás de cada dato, hay una parte de cada usuario. La protección de esta información debe estar en el centro del proceso de evolución del chatbot.

La mejora continua ofrece un marco estructurado para:

- Identificar vulnerabilidades

- Ajustar los permisos

- Reforzar los protocolos de cifrado

- Asegurar el cumplimiento de las normativas vigentes

Es un trabajo minucioso, a menudo invisible para el usuario, pero cuyo impacto se mide a largo plazo a través de la confianza que un cliente deposita en una interfaz "automatizada".

Permanecer alineado con la estrategia de la empresa

Un chatbot no debe concebirse como un elemento aislado. Debe formar parte de una lógica empresarial, de una visión más amplia.

A medida que evolucionan las prioridades internas, lanzamiento de un nuevo producto, evolución del sales pitch, cambio en el tono de comunicación, el agente conversacional debe ajustarse para reflejar esos cambios.

Eso es precisamente lo que permite la mejora continua: una actualización regular, no solo técnica, sino también estratégica, garantizando que el chatbot LLM siga siendo una herramienta coherente y útil para todos los implicados.

¿Se puede realmente optimizar el recorrido de los clientes con un chatbot LLM?

Esta pregunta merece más que una respuesta banal y rápida. Detrás del entusiasmo por estos modelos se esconde un potencial mucho más amplio de lo que parece a primera vista: un potencial que, bien aprovechado, transforma no solo los puntos de contacto, sino también la manera en que una empresa orquesta toda su relación con el cliente.

Una interacción pensada a escala de cada usuario

Cuando un chatbot LLM ajusta sus respuestas a la luz de un historial, datos cruzados del CRM o elementos contextuales, no se limita a reformular un mensaje. Da consistencia a la relación.

Es en el corazón de este enfoque donde nace la pertinencia, aquella que puede dar en el blanco desde las primeras palabras. Es a menudo en ese momento cuando se dibuja una buena experiencia de usuario.

La inmediatez es un estándar

Hubo un tiempo en que esperar formaba parte del juego. Hoy, ese paradigma se ha invertido. Ahora, el cliente es menos paciente: cambia rápidamente a otra cosa o puede frustrarse.

Ofrecer una respuesta al instante, a cualquier hora, no es un favor, es un estándar implícito que los LLM cumplen sin pestañear.

Las consultas simples se atienden al momento, liberando recursos humanos para intervenciones más finas y sensibles. Y si la rapidez no basta para fidelizar a tus clientes, al menos evita decepcionarlos.

El chatbot LLM puede interpretar lo no dicho

En toda interacción con un cliente, lo expresado es solo una parte del mensaje. El tono, las dudas, las palabras elegidas a veces dicen más que el contenido literal. ¿Sabes? Eso de la forma y el fondo.

Algunos modelos LLM, cuando están bien entrenados, logran detectar estas señales llamadas “débiles”, como una frustración latente, una insatisfacción disfrazada de cortesía, o una duda marcada.

Adaptar la respuesta a este conjunto de indicios es poner un hito hacia un servicio más humano, paradójicamente posible gracias a la máquina.

Los chatbots facilitan el acceso a la información

No es raro que el cliente se sienta perdido ante documentación pesada o FAQ laberínticas que dan vueltas en círculo. Los LLM juegan aquí un papel intermediario.

Al reformular, sintetizar o extraer la información pertinente de fuentes a menudo dispersas, hacen el conocimiento más digerible.

Es una forma de inteligencia útil, que en sí misma no es espectacular, pero sí profundamente valiosa.

Una asistencia omnicanal

En un ecosistema donde los canales se multiplican (chat web, WhatsApp, teléfono, redes sociales…), la coherencia es un desafío central.

Un usuario que comienza una consulta por el sitio web y la continúa en una mensajería móvil espera continuidad.

Los LLM, cuando se integran fluidamente en todos estos puntos de contacto, permiten esa homogeneidad.

Es una garantía de seriedad, la que asociamos a marcas fiables, predecibles y profesionales.

Chatbot LLM: mucho más que una simple herramienta

Durante mucho tiempo limitados a intercambios previsibles, los chatbots están experimentando hoy una verdadera transformación. Impulsados por los avances de los modelos de lenguaje (LLM), se liberan de los scripts lineales para ofrecer interacciones mucho más matizadas, casi naturales. Estos asistentes IA captan el contexto, reformulan y se adaptan.

Sin embargo, esta inteligencia aparente no lo es todo. Detrás de un chatbot realmente útil se esconde una arquitectura pensada, donde nada se deja al azar:

- Pertinencia de los casos de uso

- Calidad del entrenamiento

- Diseño de la interfaz

- Análisis continuo del desempeño

Estos son tantos parámetros que hay que ajustar con cuidado: una herramienta mal calibrada puede volverse rápidamente contraproducente, incluso frustrante para el usuario.

Desarrollar un asistente IA no es, por tanto, ni un proyecto accesorio ni una simple moda. Es un enfoque estratégico, exigente pero prometedor: bien integrado, facilita el recorrido del cliente y absorbe las solicitudes recurrentes.

💡 ¿Y si fuera el momento adecuado para repensar la manera en que interactúas con tus clientes o prospectos? El asistente IA de Ringover te permite construir un agente conversacional a tu imagen, capaz de dialogar inteligentemente con tus visitantes, guiarlos, calificarlos incluso cuando tus oficinas están cerradas.

Una solución diseñada para conjugar eficacia comercial y calidad de experiencia, sin compromisos. Contacta a nuestros expertos en IA y solicita una demo.

FAQs sobre Chatbot LLM

¿Qué es un chatbot LLM?

Un chatbot LLM es un agente conversacional alimentado por un gran modelo de lenguaje. A diferencia de los sistemas basados en reglas, se apoya en una comprensión estadística del lenguaje para interactuar de manera fluida, con un grado de adaptabilidad mucho mayor. Estas herramientas pueden analizar una pregunta, reformularla internamente y luego responder de forma coherente, incluso fuera de los escenarios previstos.

Chatbot y grandes modelos de lenguaje: ¿cuáles son los retos para las empresas?

Los chatbots basados en LLM plantean cuestiones importantes, tanto técnicas como estratégicas:

- Comprensión fina del lenguaje natural: No se trata solo de sintaxis o vocabulario, sino de la capacidad para captar las intenciones reales de los usuarios y responder con pertinencia.

- Adaptabilidad continua: Algunos modelos están diseñados para integrar nuevos datos y ajustar sus respuestas con el tiempo, permitiendo que los agentes evolucionen según el uso, en lugar de quedarse estáticos.

- Posibilidad de pasar a un asesor humano: Esto sigue siendo una salvaguarda indispensable. Incluso los mejores algoritmos tienen sus límites, y saber cuándo es necesaria la intervención humana garantiza una interacción sin callejones sin salida.

¿Qué es un gran modelo de lenguaje?

Un gran modelo de lenguaje (LLM, por sus siglas en inglés Large Language Model) es un sistema de inteligencia artificial entrenado para comprender, predecir y generar texto en lenguaje natural. Generalmente se basa en una arquitectura llamada transformer, un tipo de red neuronal que sobresale en el procesamiento de secuencias complejas.

Gracias a un entrenamiento con grandes volúmenes de texto de diversas fuentes, estos modelos desarrollan una forma de “conocimiento implícito” del lenguaje. Esto no significa que entiendan el mundo como los humanos, sino que saben identificar regularidades, matices e incluso, a veces, insinuaciones.

¿Cuál es la diferencia entre un chatbot tradicional y un chatbot LLM?

El chatbot tradicional o simple se basa en escenarios predefinidos, con reglas condicionales y respuestas programadas previamente. Es eficaz para solicitudes simples y repetitivas, pero muestra rápidamente sus límites cuando una consulta se sale del marco previsto.

Un chatbot LLM, en cambio, no necesita “estar avisado” de todas las preguntas posibles. Analiza la consulta en tiempo real, deduce el sentido y formula una respuesta adaptada, incluso si la formulación inicial es confusa, ambigua o inédita. No reemplaza los escenarios de negocio, sino que los complementa con una flexibilidad muy apreciable.

¿Cuáles son los grandes LLM?

El auge de la inteligencia artificial en los últimos años ha dado lugar a una nueva generación de modelos de lenguaje con capacidades impresionantes. Algunos se han convertido en referencias industriales; otros, más recientes, buscan redefinir los estándares apoyándose en enfoques abiertos o arquitecturas más específicas.

- GPT4 – OpenAI: Desde su lanzamiento, GPT-4 genera tanto interés como especulación. OpenAI no ha comunicado cifras precisas sobre la cantidad de parámetros, manteniendo cierto misterio, aunque varias fuentes hablan de tamaños muy superiores a la generación anterior (¡175 mil millones!). Lo que distingue a GPT-4, más allá de su potencia bruta, es su capacidad para interpretar consultas complejas con un sentido agudo del contexto, incluso en áreas muy especializadas.

- LLaMA 3 – Meta: Presentado en 2024, LLaMA 3 (Large Language Model Meta AI) está disponible en varios tamaños —de 8 a 70 mil millones de parámetros— y apuesta por el open source, una estrategia que atrae a un número creciente de actores que buscan transparencia o autonomía técnica. En algunas tareas, como el razonamiento lógico o la codificación, supera a modelos más grandes, demostrando que la optimización fina a veces es tan importante como la potencia de cálculo.

- Mistral – Mistral AI: En un panorama dominado por gigantes estadounidenses, Mistral AI, empresa francesa, ofrece una alternativa creíble y eficiente. Su modelo, también open source, está pensado para funcionar de forma descentralizada, facilitando su despliegue local o en infraestructuras controladas. Una orientación que atrae tanto por motivos técnicos como regulatorios.

- Falcon 180B: Diseñado en Emiratos Árabes Unidos, Falcon 180B destaca por su tamaño —180 mil millones de parámetros— y por ser open source, algo raro en este nivel. Es especialmente valorado en contextos donde las empresas buscan entrenar o adaptar un modelo a gran escala sin depender de una API propietaria.

- Gemini: Sucesor de Bard, Gemini representa la nueva generación de modelos desarrollados por Google DeepMind. Diseñado para ser multimodal (capaz de procesar texto, imágenes, audio y código) e integrado nativamente en el ecosistema Google, esta familia de modelos aspira a combinar potencia, flexibilidad y facilidad de uso. Si Bard fue un primer paso en interfaces conversacionales hechas por Google, Gemini apunta claramente al uso profesional a gran escala.

Publicado el 20 Mayo 2025.